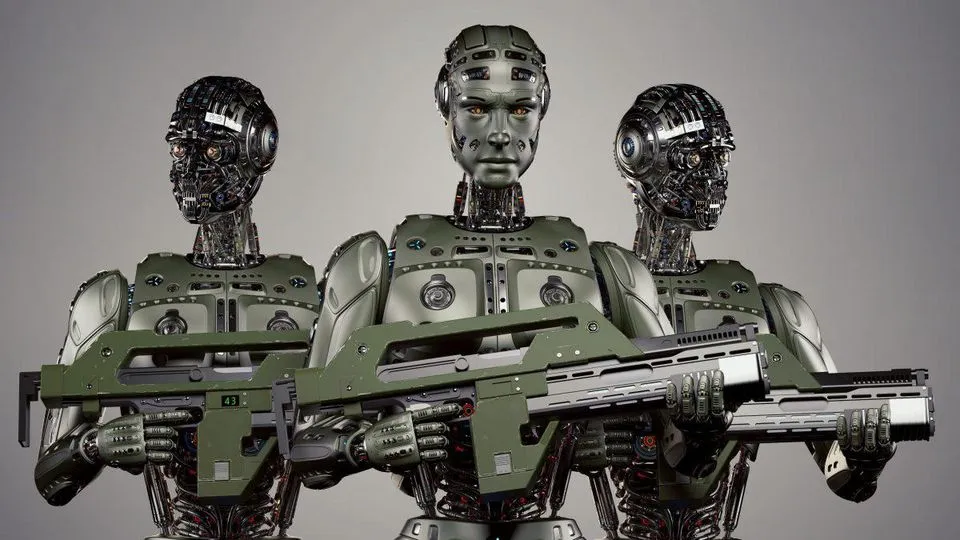

به گزارش ایسنا، توسعه سلاحهای مرگبار خودمختار(LAWs)، از جمله پهپادهای مجهز به هوش مصنوعی، در حال افزایش است. به عنوان مثال، وزارت دفاع ایالات متحده تاکنون یک میلیارد دلار برای برنامه رپلیکیتور(Replicator) خود در نظر گرفته است که هدف آن ساخت ناوگانی از وسایل نقلیه خودران کوچک و تسلیحاتی است. زیردریاییها، تانکها و کشتیهای آزمایشی ساخته شدهاند که از هوش مصنوعی برای خلبانی و شلیک استفاده میکنند. پهپادهای تجاری موجود میتوانند از قابلیت تشخیص تصویر هوش مصنوعی برای رسیدن به اهداف استفاده کرده و آنها را منفجر کنند. سلاحهای خودمختار مرگبار برای کار کردن به هوش مصنوعی نیاز ندارند، اما این فناوری، سرعت، ویژگی و توانایی فرار را به آنها اضافه میکند. برخی از ناظران از آیندهای بیم دارند که در آن انبوهی از پهپادهای ارزان هوش مصنوعی توسط هر جناحی برای از بین بردن یک فرد خاص با استفاده از فناوری تشخیص چهره اعزام شوند.

به نقل از نیچر، در جنگ میان روسیه و اوکراین، فیلمهای ویدئویی نشان میدهد که پهپادها به خاک روسیه تا بیش از ۱۰۰۰ کیلومتری مرز نفوذ کرده و زیرساختهای نفت و گاز را تخریب کردهاند. به گفته کارشناسان، احتمالا هوش مصنوعی(AI) به هدایت پهپادها به سمت اهدافشان کمک کرده است. برای استفاده از چنین سلاحهایی، به حضور هیچ فردی برای نگه داشتن ماشه یا تصمیم نهایی برای انفجار نیاز نیست.

وارفر(Warfare) یک برنامه نسبتا ساده برای هوش مصنوعی است. استوارت راسل(Stuart Russell) دانشمند رایانه در دانشگاه کالیفرنیا، برکلی، و یک مبارز برجسته علیه سلاحهای هوش مصنوعی میگوید: قابلیت فنی یک سیستم برای یافتن یک انسان و کشتن آن بسیار سادهتر از توسعه یک ماشین خودران است.

ظهور هوش مصنوعی در میدان نبرد بحثهایی را در میان محققان، کارشناسان حقوقی و اخلاقشناسان برانگیخته است. برخی استدلال میکنند که سلاحهایی که به کمک هوش مصنوعی کار میکنند میتوانند از سلاحهای هدایت شونده توسط انسان دقیقتر باشند و به طور بالقوه باعث کاهش آسیبهای جانبی مانند تلفات غیرنظامی و آسیب به مناطق مسکونی و کاهش تعداد سربازان کشته و معلول شوند و در عین حال به کشورها و گروههای آسیبپذیر برای دفاع کمک کنند. برخی دیگر تأکید میکنند که سلاحهای خودمختار ممکن است اشتباهات فاجعه باری را مرتکب شوند و بسیاری از ناظران نگرانیهای اخلاقی فراگیر در مورد انتقال تصمیمات هدفگذاری به یک الگوریتم دارند.

سالهاست که محققان برای کنترل این تهدید جدید مبارزه میکنند. اکنون سازمان ملل گامی تعیین کننده برداشته است. قطعنامهای در ماه دسامبر سال گذشته موضوع سلاحهای خودمختار کشنده را به دستور جلسه مجمع عمومی سازمان ملل در ماه سپتامبر امسال اضافه کرد. و آنتونیو گوترش(António Guterres)، دبیرکل سازمان ملل متحد در ژوئیه سال گذشته اظهار داشت که میخواهد تا سال ۲۰۲۶ ممنوعیت سلاحهایی که بدون نظارت انسان عمل میکنند اعمال شود. بانی دوچرتی(Bonnie Docherty)، وکیل حقوق بشر در دانشکده حقوق هاروارد در کمبریج، ماساچوست، میگوید که این موضوع در دستور کار سازمان ملل پس از یک دهه یا بیشتر قابل توجه بوده است. او میگوید: دیپلماسی به کندی پیش میرود، اما گام مهمی است.

کارشناسان میگویند این اقدام اولین مسیر واقع بینانه را برای دولتها ارائه میدهد تا بر روی سلاحهای هوش مصنوعی کار کنند. اما گفتنش از انجام دادنش آسانتر است. این تسلیحات سوالات دشواری را در مورد عامل انسانی، مسئولیتپذیری و میزانی که مقامات باید بتوانند تصمیمات مرگ و زندگی را به ماشینها واگذار کنند، ایجاد میکند.

تحت کنترل در آوردن

تلاشها برای کنترل و تنظیم استفاده از سلاحها به صدها سال قبل باز میگردد. برای مثال، شوالیههای قرون وسطی توافق کردند که اسبهای یکدیگر را با نیزههای خود هدف قرار ندهند. در سال ۱۶۷۵، کشورهای فرانسه و امپراتوری روم موافقت کردند که استفاده از گلولههای سمی را ممنوع کنند.

امروزه، عمدهترین محدودیتهای بینالمللی در مورد تسلیحات از طریق کنوانسیون سازمان ملل متحد در مورد برخی سلاحهای متعارف(CCW)، معاهدهای در سال ۱۹۸۳ است که به عنوان مثال برای ممنوعیت سلاحهای لیزری کور کننده استفاده شده است.

تسلیحات خودمختار دستکم دهههاست که وجود داشتهاند، از جمله موشکهای گرمایاب و حتی مینهای زمینی که با فشار کار میکنند و قدمت آنها به جنگ داخلی آمریکا برمیگردد. با این حال، اکنون توسعه و استفاده از الگوریتمهای هوش مصنوعی در حال گسترش قابلیتهای چنین سلاحهایی است.

کنوانسیون سازمان ملل متحد در مورد برخی سلاحهای متعارف از سال ۲۰۱۳ به طور رسمی در حال بررسی تسلیحات تقویت شده با هوش مصنوعی بوده است، اما از آنجا که برای تصویب مقررات به اجماع بینالمللی نیاز دارد و به دلیل اینکه بسیاری از کشورهایی که فعالانه این فناوری را توسعه میدهند مخالف هرگونه ممنوعیتی هستند، پیشرفت این روند کند بوده است.

بخشی از مشکل عدم اجماع در مورد این است که سلاحهای خودمختار کشنده واقعا چه هستند.

یک تجزیه و تحلیل در سال ۲۰۲۲ حداقل دهها تعریف از سیستمهای تسلیحاتی خودمختار ارائه شده توسط کشورها و سازمانهایی مانند سازمان پیمان آتلانتیک شمالی(ناتو) را پیدا کرد. راسل میگوید که این تعاریف طیف وسیعی را در بر میگیرد و میزان توافق یا حتی درک محدود از هوش مصنوعی را نشان میدهد.

برای مثال، بریتانیا میگوید سلاحهای خودمختار کشنده «قادر به درک هدف و جهت سطح بالاتر» هستند، در حالی که چین میگوید چنین سلاحی میتواند «به طور مستقل بیاموزد، عملکردها و قابلیتهای خود را به گونهای فراتر از انتظارات انسانی گسترش دهد». آلمان «خودآگاهی» را بهعنوان یک ویژگی ضروری سلاحهای خودمختار در نظر میگیرد که اکثر محققان میگویند با آنچه امروزه از هوش مصنوعی برمیآید، بسیار فاصله دارد.

راسل میگوید: این نوع خودآگاهی به این معنی است که سلاح باید صبح از خواب بیدار شود و تصمیم بگیرد که به تنهایی به روسیه حمله کند.

اگرچه تعریف جامعتر، خاصتر و واقعبینانهتر برای سلاحهای خودمختار کشنده باید مشخص شود، اما برخی از کارشناسان میگویند که میتوان منتظر ماند. دوچرتی میگوید: معمولا یک تعریف کارآمد برای شروع فرآیند کافی است و میتواند به کاهش اعتراضات اولیه کشورهای مخالف اقدام کمک کند.

مزیت هوش مصنوعی

بر اساس تحلیلی که در سال ۲۰۲۳ توسط مرکز مطالعات جنگ در دانشگاه جنوبی دانمارک منتشر شد، سلاحهای خودمختار هدایتشده توسط هوش مصنوعی که امروزه در اختیار فرماندهان ارتش قرار دارد، نسبتا خام هستند. و شامل پهپادهایی با حرکت کُند و ناشیانه مجهز به مواد منفجره کافی برای منفجر کردن خودشان و اهدافشان میشوند.

این «مهمات سرگردان» میتواند به اندازه یک هواپیمای مدل باشد، قیمتی در حدود ۵۰ هزار دلار داشته باشد و چند کیلوگرم مواد منفجره را تا فاصله ۵۰ کیلومتری حمل کند که برای نابودی یک وسیله نقلیه یا کشتن سربازان کافی است.

این مهمات از حسگرهای روی برد استفاده میکنند که فرکانسهای نوری، مادون قرمز یا رادیویی را برای شناسایی اهداف بالقوه نظارت میکنند. هوش مصنوعی این ورودیهای حسگر را با پروفایلهای از پیش تعیینشده تانکها، خودروهای زرهی و سیستمهای راداری و همچنین انسانها مقایسه میکند.

ناظران میگویند که مهمترین مزیت این بمبهای خودمختار نسبت به پهپادهای کنترل از راه دور این است که اگر طرف مقابل تجهیزاتی برای مسدود کردن ارتباطات الکترونیکی داشته باشد، همچنان آنها کار میکنند.

اگرچه شایعاتی مبنی بر کشته شدن جنگجویان در لیبی توسط مهمات خودمختار در سال ۲۰۲۰ وجود داشت، گزارشهای مربوط به درگیری در اوکراین این ایده را تقویت کرده است که اکنون از پهپادهای هوش مصنوعی استفاده میشود.

سخت است که بدانیم سلاحهای هوش مصنوعی در میدان جنگ چقدر خوب عمل میکنند، تا حد زیادی به این دلیل که ارتشها چنین دادههایی را منتشر نمیکنند. تام کوپینگر-سایمز (Thomas Copinger-Symes)، معاون فرمانده فرماندهی استراتژیک بریتانیا، در پاسخ به پرسشی مستقیم در مورد سیستمهای تسلیحاتی هوش مصنوعی سال گذشته، اظهار نظر چندانی نکرد و تنها گفت که ارتش این کشور در حال انجام مطالعات است.

اگرچه دادههای میدان جنگ در دنیای واقعی پراکنده است، محققان خاطرنشان میکنند که هوش مصنوعی مهارتهای پردازش و تصمیمگیری برتری دارد که از نظر تئوری، مزیت قابل توجهی را ارائه میدهد. برای مثال، در آزمایشهای سالانه تشخیص سریع تصویر، الگوریتمها تقریبا برای یک دهه از عملکرد افراد متخصص بهتر عمل کردهاند. برای مثال، یک مطالعه در سال گذشته نشان داد که هوش مصنوعی میتواند تصاویر تکراری را در مقالات علمی سریعتر و جامعتر از یک متخصص انسانی پیدا کند.

در سال ۲۰۲۰، یک مدل هوش مصنوعی به لطف «مانورهای تهاجمی و دقیقی که خلبان انسانی نمیتوانست از پس آن بربیاید»، خلبان باتجربه هواپیمای جنگنده F-۱۶ را در یک مجموعه نبردهای شبیهسازی شده شکست داد. سپس، در سال ۲۰۲۲، محققان نظامی چینی گفتند که یک پهپاد مجهز به هوش مصنوعی، هواپیمایی را که از راه دور توسط یک اپراتور انسانی روی زمین به پرواز در میآمد، فریب داده است. هواپیمای هوش مصنوعی در موقعیتی قرار گرفت که میتوانست رقیب خود را ساقط کند.

زاک کالنبورن(Zak Kallenborn)، تحلیلگر امنیتی در مرکز مطالعات استراتژیک و بینالمللی در واشنگتن دیسی میگوید: هوش مصنوعی پهپاد میتواند تصمیمگیریهای بسیار پیچیدهای در مورد نحوه انجام مانورهای خاص، نزدیک شدن به حریف و زاویه حمله بگیرد.

کالنبورن میگوید هنوز مشخص نیست که سلاحهای هوش مصنوعی چه مزیت استراتژیک مهمی را ارائه میدهند، به خصوص اگر هر دو طرف به آنها دسترسی داشته باشند. او افزود: بخش بزرگی از مسئله، خود فناوری نیست، بلکه نحوه استفاده ارتشها از آن فناوری است.

هوش مصنوعی همچنین میتواند در جنبههای دیگر جنگ، از جمله تهیه فهرستی از اهداف بالقوه استفاده شود.

خطی در شن و ماسه

یکی از معیارهای کلیدی که اغلب برای ارزیابی اخلاقیات سلاحهای خودمختار استفاده میشود این است که تا چه حد قابل اعتماد هستند و تا چه حد ممکن است کارها اشتباه پیش بروند.

کالنبورن میگوید سلاحهای هوش مصنوعی میتوانند به راحتی روی سیگنالهای راداری مادون قرمز یا قدرتمند قفل شوند و آنها را با مجموعهای از دادهها مقایسه کنند. این بدان معناست که وقتی یک سلاح هوش مصنوعی منبع سیگنال راداری ورودی را در میدان جنگ شناسایی میکند، میتواند با خطر کمی برای آسیب رساندن به غیرنظامیان، شلیک را انجام دهد.

او میگوید، اما تشخیص تصویر بصری مشکل سازتر است. جایی که اساسا فقط یک حسگر مانند دوربین وجود دارد، من فکر میکنم که شما خیلی بیشتر در معرض خطا هستید. اگرچه هوش مصنوعی در شناسایی تصاویر خوب است، اما بیخطا نیست. او میگوید تحقیقات نشان داده است که تغییرات کوچک در تصاویر میتواند نحوه دستهبندی آنها توسط شبکههای عصبی را تغییر دهد و برای مثال باعث شود که یک هواپیما با یک سگ اشتباه گرفته شود.

یکی دیگر از خطوط تقسیمبندی برای اخلاق شناسان این است که چگونه از یک سلاح استفاده میشود: برای حمله یا دفاع.

سیستمهای خودمختار پیچیده هدایت شونده با رادار در حال حاضر برای دفاع از کشتیها در دریا استفاده میشود. لوسی ساچمن(Lucy Suchman)، جامعهشناس در دانشگاه لنکستر، بریتانیا، که تعاملات بین انسانها و دستگاهها را مطالعه میکند، میگوید که اخلاقدانان با این نوع سلاحهای خودمختار راحتتر هستند، زیرا به جای افراد، مهمات را هدف قرار میدهند و به سختی میتوان سیگنالهای آنها را به اشتباه به چیز دیگری نسبت داد.

یکی از اصول رایج پیشنهادی در بین محققان و ارتش این است که انسان در حلقه سلاحهای خودمختار وجود داشته باشد. اما اینکه مردم کجا و چگونه باید درگیر شوند هنوز مورد بحث است. بسیاری از افراد، از جمله ساچمن، معمولا این ایده را به این معنا تفسیر میکنند که عوامل انسانی باید قبل از صدور مجوز حملات، اهداف را به صورت بصری بررسی کنند و در صورت تغییر شرایط میدان نبرد مانند ورود غیرنظامیان به منطقه نبرد باید بتوانند حمله را متوقف کنند.

برخی از سیستمها به کاربران اجازه میدهند تا بسته به شرایط، بین حالتهای کاملا مستقل و با هدایت انسان تغییر حالت بدهند. ساچمن و دیگران میگویند این به اندازه کافی خوب نیست. او میگوید: مجبور کردن یک انسان برای غیرفعال کردن یک عملکرد مستقل، کنترل معنیداری ایجاد نمیکند. راسل پیشنهاد میکند که شلیک باید توسط یک اپراتور از راه دور فعال شود و هرگز توسط هوش مصنوعی فعال نشود.

دستکم یک نکته در بحث سلاحهای خودمختار کشنده وجود دارد که به نظر میرسد تقریبا همه حتی کشورهایی که عموما مخالف کنترل هستند، بر آن توافق دارند و آن تصمیم برای پرتاب سلاحهای هستهای است.

کنترل کردن سیستم

کالنبورن میگوید متأسفانه هرگونه ممنوعیت استفاده از سلاحهای خودمختار از طریق بازرسیها و مشاهدات به سختی اعمال میشود.

برای مثال، در مورد سلاحهای هستهای، یک سیستم برای بازرسی مکانها و ممیزی مواد هستهای وجود دارد. اما با هوش مصنوعی، پنهان کردن یا تغییر موارد گوناگون در پرواز آسانتر است.

همه این مسائل وارد بحثهای سازمان ملل خواهد شد که در مجمع عمومی سپتامبر امسال آغاز میشود. یک کنفرانس پیشرو نیز توسط اتریش در پایان آوریل برگزار شده است تا به شروع این گفتگوها کمک کند. اگر تعداد کافی از کشورها در ماه سپتامبر به اقدام رأی دهند، احتمالا سازمان ملل کارگروهی را برای تعیین این مسائل تشکیل خواهد داد.

دوچرتی که نقشی کلیدی در مذاکرات پیمان منع تسلیحات هستهای سازمان ملل در سال ۲۰۱۷ داشت، اضافه میکند که ممکن است یک معاهده ظرف سه سال ارائه شود. طبق تجربه من، پس از شروع مذاکرات، این روند نسبتا سریع پیش میرود.

انتهای پیام

نظرات