به گزارش ایسنا، روزنامه «هممیهن» نوشت: در کنار امکانات فراوانی که فناوری مبتنی بر هوش مصنوعی برای انسان فراهم میکند، احتمالا مخاطرات و آسیبهایی هم با خود بهدنبال خواهد داشت. بههمین دلیل نیز بسیاری از دانشگاههای دنیا پروژههای پژوهشی را تعریف کردند تا اثرات مثبت و منفی این تحول بزرگ در عرصه فناوری را بر سایر حوزه مطالعه کنند. در این میان، Chat GPT و سایر ChatBotهای مبتنی بر هوش مصنوعی، توجه بسیاری از پژوهشگران و علاقهمندان به فناوری را بهخود جلب کردهاند. روزی نیست که مطلب جدیدی راجع به امکانات Chat GPT و فرصتهای آن بحث نشود.

یکی از امکانات جذاب Chat GPT تولید متن و محتواست. این ChatBot بر اساس درخواستی که از آن داریم، اقدام به تولید محتوا و متن میکند. امکان تولید متن و محتوا با بهکارگیری Chat GPT اگرچه فرصتهایی را در اختیار افراد و شرکتهای تجاری قرار میدهد، اما تهدیداتی را هم با خود بهدنبال دارد. یکی از این تهدیدها، گسترش اخبار جعلی و حتی اکانتهای جعلی است. امروزه مبارزه با اخبار جعلی یکی از دغدغههای مهم خبرنگاران، پژوهشگران و نهادهای مدنی و دولتی است و توسعه الگوریتمهای مناسب برای تشخیص اخبار جعلی و اکانتهای فیک در دستور کار آنها قرار دارد. اما با ظهور هوش مصنوعی مولد، ماجرا پیچیدهتر میشود.

یک کاربر توئیتری را تصور کنید که بهطور مرتب از دیگران انتقاد میکند. هر توئیتی را که نگاه میکنید، انتقاد آن کاربر را پایین آن توئیت میبینید و از خود سوال میپرسید که این کاربر چطور فرصت میکند در تمام ساعات شبانهروز از دیگران انتقاد کند! این کار میتواند با کمک Chat GPT و بهطور اتوماتیک انجام شود. تنها کافی است که آن اکانت به Chat GPT متصل باشد و بهطور اتوماتیک هر توئیتی میبیند برای Chat GPT بفرستد و از آن بخواهد تا یک متن انتقادی راجع به آن توئیت بنویسد. سپس نتیجه را در توئیتر بهطور اتوماتیک منتشر کند. شاید بهنظر بیاید این کار شدنی نیست و Chat GPT هنوز به آن مرحله نرسیده است که چنین خروجیای داشته باشد.

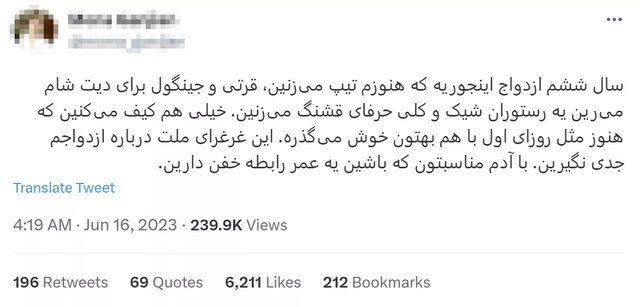

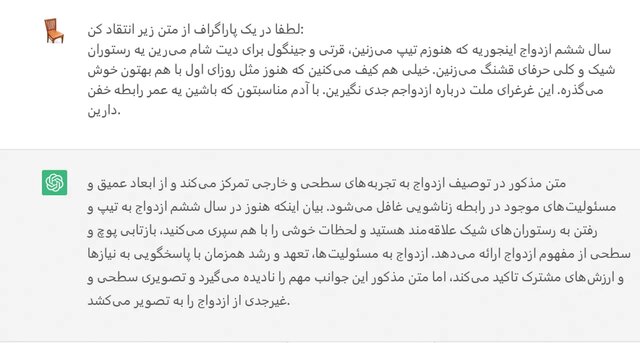

من برای امتحان و بررسی این روش، یک توئیت از کاربری را به Chat GPT دادم و از آن خواستم تا نقدی بر این توئیت بنویسد. متن توئیت و پاسخ Chat GPT را در ادامه میتوانید ببینید:

در کمال شگفتی، Chat GPT نسبتا پاسخ انتقادی خوبی به توئیت اولیه داده است. امری که نشان میدهد این ChatBot حتی در تشخیص زبان روزمره فارسی و ارائه پاسخ به آن نسبتاً خوب عمل میکند. حال تصور کنید آن اکانت توئیتری مرتباً توئیتهای مربوط به یک موضوع خاص را بهطور اتوماتیک به Chat GPT بدهد و پاسخ آن را نیز در پایین هر توئیت کامنت بگذارد. اینگونه یک اکانت بدون اینکه توسط شخص خاصی اداره شود، مرتباً فعال است و علیه دیگران کامنت میگذارد بدون آنکه دیگران متوجه شوند هیچکسی پشت آن اکانت نیست.

همین قابلیت میتواند در خدمت ساخت اکانتها و اخبار جعلی قرار بگیرد. با توجه به این امکانات، شاید در آینده نزدیک اکانتهایی در شبکههای اجتماعی فعال شوند که عملاً توسط هوش مصنوعی و بهطور اتوماتیک اداره میشوند اما امکان تشخیص آن از یک کاربر واقعی دشوار باشد. در نتیجه این کاربر بهمرور با فعالیت مستمر در آن شبکه اجتماعی میتواند جذب فالوئر کند، درحالیکه هیچکسی پشت آن نیست. این کاربر همچنین میتواند با ادبیاتی شبیه به دیگران محتوایی تولید کند که باورپذیر بوده، اما از اساس غلط و دروغ باشد. تا امروز عامل انسانی در کنار هوش مصنوعی نقش مهمی در شناسایی اخبار جعلی داشته است؛ اما افزایش پیچیدگی اخبار جعلی، احتمال شناسایی این قبیل خبرها دشوارتر شود.

نگرانی در خصوص ایجاد اکانتهای جعلی که بهطور اتوماتیک و از طریق هوش مصنوعی اداره میشوند، نگرانی جدیدی نیست. مدتهاست که در شبکههای اجتماعی نظیر توئیتر رباتها در قالب اکانتهای جعلی فعالیت میکنند، کامنت میگذارند و محتوا تولید میکنند. اما این رباتها معمولا بهراحتی قابل تشخیص بودند چراکه محتوایی تولید میکردند که عمدتاً نامفهوم بود و یا چندان مربوط به بحث نبود. اما حالا با توسعه مدلهای زبانی و ظهور هوش مصنوعی مولد، ضعف این نوع اکانتها برطرف شده و در سالهای آینده شاهد ظهور اکانتهایی خواهیم بود که هیچ انسانی آن را اداره نمیکند اما در شبکههای اجتماعی تولید محتوا و فعالیت مؤثر میکنند. وینسنت کانیتزر، استاد علوم کامپیوتر، در همین رابطه میگوید: «چیزی مانند Chat GPT میتواند اکانتهای جعلی را در سطحی بیسابقه گسترش دهد و تشخیص هر یک از این اکانتها توسط انسان سختتر از پیش خواهد شد».

با این حساب، بهنظر میرسد توسعه هوش مصنوعی مولد حتی نوع کنشگری در شبکههای اجتماعی را نیز دستخوش تغییر کند. بعید نیست در آینده نزدیک شاهد ظهور اکانتهای پرفالوئری باشیم که با توجه به تحولات روز، بهخوبی تولید محتوا میکنند و بههمین دلیل فالوئر جذب میکنند، اما هیچکسی آنها را اداره نمیکند بدون آنکه کسی متوجه شود. از آنجایی که این اکانتها به منبع قدرتی برای گروهها و جریانات سیاسی تبدیل میشوند، بهرهگیری از آنها توسط صاحبان قدرت و ثروت روزافزون خواهد بود. در نتیجه ابعاد جدید و پیچیدهتری از «پروپاگاندای رایانشی» ظهور خواهد کرد. در نتیجه پروپاگاندا در فضای آنلاین نهفقط توسط رفتارهای غیراصل سازماندهی شده (Coordinated Inauthentic Behavior) و رباتهایی که تشخیصشان آسان است، ممکن میشود، بلکه در لایه پیچیدهتری شاهد ظهور اکانتهایی خواهیم بود که حتی ممکن است با ما همراهی و همدلی داشته باشند و در مواضع سیاسی با آنها بحث کنیم، اما پشت آن هیچ عامل انسانی حضور نداشته باشد.

بدینترتیب همه کاربران شبکههای اجتماعی بهطور دائم تحت تأثیر پروپاگاندای دولتها و جریانهای سیاسی قرار میگیرند و حتی امکان تشخیص آن را نیز نخواهند داشت. امری که میتواند جنس فعالیت در شبکههای اجتماعی و خصوصاً کنشگری سیاسی در آن را دستخوش تحولات فراوان کند. در یک جمعبندی کلی باید گفت که هوش مصنوعی مولد، مانند انواع دیگر فناوری، توأمان فرصتها و تهدیداتی را ایجاد میکند که باید آگاهانه با آنها روبهرو شد. فناوری همراه با خود فرصتها و تهدیدهایی را با هم میآورد و از همین تکنولوژی نیز باید برای کنترل تهدیدها و شناسایی آنها بهره گرفت و چهبسا امکان طراحی الگوریتمی برای شناسایی همین اکانتهای جعلی نیز ممکن شود. آنچه مسلم است آن است که آینده بسیار متفاوت از امروز خواهد بود.

انتهای پیام

نظرات